El jueves, Meta dio a conocer las primeras versiones de su Llama 3 Modelo de IA de peso abierto que se puede utilizar para impulsar la composición de texto, la generación de código o chatbots. También anunció que su Asistente de MetaIA es ahora disponible en un sitio web y se integrará en sus principales aplicaciones de redes sociales, intensificando los esfuerzos de la compañía para posicionar sus productos frente a otros asistentes de inteligencia artificial como ChatGPT de OpenAI, Copilot de Microsoft y Gemini de Google.

Al igual que su predecesor, Llama 2, Llama 3 se destaca por ser un modelo de lenguaje grande (LLM) de peso abierto y disponible gratuitamente proporcionado por una importante empresa de inteligencia artificial. Llama 3 técnicamente no califica como «código abierto» porque ese término tiene un significado específico en software (como hemos mencionado en otra cobertura), y la industria aún no se ha decidido por la terminología para los lanzamientos de modelos de IA que incluyen código o pesos con restricciones (puede leer la licencia de Llama 3 aquí) o ese barco sin proporcionar datos de entrenamiento. Normalmente llamamos a estos lanzamientos «pesos abiertos».

Por el momento, Llama 3 está disponible en dos tamaños de parámetros: 8 mil millones (8B) y 70 mil millones (70B), los cuales están disponibles como descargas gratuitas a través del sitio web de Meta con un inscribirse. Llama 3 viene en dos versiones: preentrenada (básicamente el modelo sin procesar de predicción del siguiente token) y ajustada por instrucciones (ajustada para seguir las instrucciones del usuario). Cada uno tiene un límite de contexto de 8192 tokens.

Benj Edwards

Meta entrenó ambos modelos en dos clústeres personalizados de 24.000 GPU. En una entrevista de podcast con Dwarkesh PatelEl director ejecutivo de Meta, Mark Zuckerberg, dijo que la compañía entrenó el modelo 70B con alrededor de 15 billones de tokens de datos. A lo largo del proceso, el modelo nunca alcanzó la «saturación» (es decir, nunca chocó contra una pared en términos de aumentos de capacidad). Finalmente, Meta desconectó y pasó a entrenar otros modelos.

«Supongo que nuestra predicción al principio era que iba a tener más asíntotas, pero incluso al final todavía se estaba inclinando. Probablemente podríamos haberle alimentado con más tokens y habría mejorado un poco», dijo Zuckerberg en el podcast.

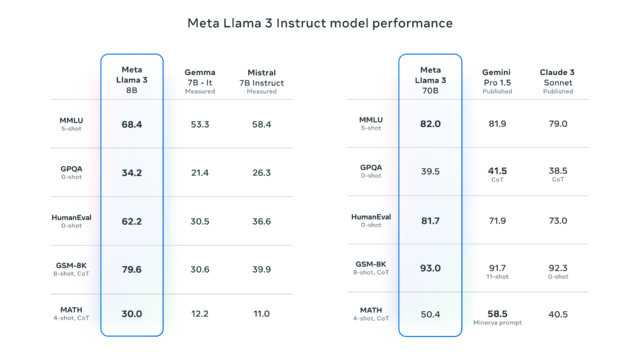

Meta también anunció que actualmente está entrenando una versión de Llama 3 con parámetros 400B, que algunos expertos como Jim Fan de Nvidia creen que puede actuar en la misma liga como GPT-4 Turbo, Claude 3 Opus y Gemini Ultra en puntos de referencia como MMLU, GPQA, evaluación humanay MATEMÁTICAS.

Hablando de puntos de referencia, hemos dedicado muchas palabras en el pasado a explicar cuán frustrantemente imprecisos pueden ser los puntos de referencia cuando se aplican a modelos de lenguaje grandes debido a problemas como la contaminación del entrenamiento (es decir, incluir preguntas de pruebas de punto de referencia en el conjunto de datos de entrenamiento), la selección selectiva de por parte de los proveedores y la incapacidad de capturar la utilidad general de la IA en una sesión interactiva con modelos sintonizados por chat.

Pero, como era de esperar, Meta proporcionó algunos puntos de referencia para Llama 3 que enumeran los resultados de MMLU (conocimientos a nivel de pregrado), GSM-8K (matemáticas de escuela primaria), evaluación humana (codificación), GPQA (preguntas de posgrado), y MATEMÁTICAS (problemas escritos de matemáticas). Estos muestran que el modelo 8B funciona bien en comparación con modelos de peso abierto como el Gemma 7B y el Google. Mistral 7B Instruct, y el modelo 70B también se mantuvo firme frente a Gemini Pro 1.5 y Claude 3 Sonnet.

Meta dice que el modelo Llama 3 se ha mejorado con capacidades para comprender la codificación (como Llama 2) y, por primera vez, se ha entrenado tanto con imágenes como con texto, aunque actualmente solo genera texto. De acuerdo a ReutersChris Cox, director de productos de Meta, señaló en una entrevista que se esperan capacidades de procesamiento más complejas (como la ejecución de planes de varios pasos) en futuras actualizaciones de Llama 3, que también admitirá salidas multimodales, es decir, tanto texto como imágenes.

Meta planea alojar los modelos Llama 3 en una variedad de plataformas en la nube, haciéndolas accesibles a través de AWS, Databricks, Google Cloud y otros proveedores importantes.

También el jueves, Meta anunció que Llama 3 se convertirá en la nueva base del asistente virtual Meta AI, que la compañía anunció por primera vez en septiembre. El asistente aparecerá de forma destacada en las funciones de búsqueda de Facebook, Instagram, WhatsApp, Messenger y los mencionados anteriormente. sitio web dedicado que presenta un diseño similar a ChatGPT, incluyendo la capacidad de generar imágenes en la misma interfaz. La compañía también anunció una asociación con Google para integrar resultados de búsqueda en tiempo real en el asistente Meta AI, sumándose a una asociación existente con Bing de Microsoft.