A medida que avanza la temporada de elecciones presidenciales en Estados Unidos, las noticias políticas falsas han comenzado a asomar su fea cara.

La desinformación y la desinformación política han sido un problema prácticamente desde los albores de la imprenta. Aunque las noticias falsas se han convertido en un tema candente en la última década, la llegada de la IA generativa, asociada con algoritmos de redes sociales potenciados, puede que solo sirva para amplificar el problema.

«(La IA) aumenta enormemente la capacidad de crear cualquier tipo de nuevo medio… tanto en velocidad como en volumen», dijo el Dr. Daniel Trielli, profesor asistente de medios y democracia en la Universidad de Maryland.

Las solicitudes de patentes revelan formas en que las empresas de tecnología pueden estar intentando obstaculizar este problema utilizando la misma tecnología que puede intensificarlo, ya sea detección de deepfake, herramientas de verificación de hechos o raspadores de spam. Pero el resultado puede reducirse a un modelo de IA versus un modelo de IA.

Cómo se hace el deepfake

Si ha utilizado Internet durante el último año, probablemente haya visto o escuchado al menos una pieza de contenido deepfake generado por IA. No siempre es malicioso; a veces es tonto y sin sentido, como los videos virales generados por IA del presidente Joe Biden y Barack Obama haciendo un dúo. «El chico es un mentiroso» por Ice Spice. En esos casos, es mucho más fácil para el consumidor promedio distinguir lo real de lo falso y darse cuenta de que Biden no tiene ese tipo de fluidez.

Los servicios para crear este tipo de contenido existen en todas partes, desde servicios de inicio hasta ofertas de firmas tecnológicas más grandes como DALL-E de OpenAI o el modelo de generación de voz Voicebox de Meta. Esta proliferación ha reducido efectivamente la barrera de entrada, permitiendo a cualquier persona con una conexión a Internet y unos minutos libres la capacidad de crear noticias falsas generadas por IA.

«Tú, yo o cualquier otra persona podemos generar defectos casi sin costo alguno», dijo Rahul Sood, director de productos de la empresa de detección de deepfake. Caída de un alfiler. «No faltan herramientas para usar (para esto) si quieres una herramienta».

Los usos extravagantes de esta tecnología aún señalan una posibilidad peligrosa: es fácil crear contenido que parezca y suene auténtico cuando no lo es. Un estudio publicado el año pasado por el University College London encontró que los participantes solo podían identificar voces deepfaked. 73% del tiempo. Las investigaciones también muestran que, a pesar de su confianza en hacerlo, La gente no puede distinguir de manera confiable imágenes y videos falsos. de los auténticos.

Y cuantos más datos estén disponibles públicamente de una cifra particular, más preciso puede ser el modelo de IA, de ahí que esta tecnología sea peligrosa en contextos políticos, dijo Sood. «Hay suficiente contenido de políticos… que puedes tomarlo para generar cualquier deepfake que quieras».

Tan sólo en los últimos meses, varias de estas situaciones han aparecido en los titulares. En enero, aproximadamente 20.000 votantes en New Hampshire recibieron llamadas automáticas generadas por IA haciéndose pasar por el presidente Biden. instando a los demócratas a no votar en las primarias del estado. A principios de este mes, BBC informó que los partidarios de Donald Trump comenzaron a hacer circular imágenes del expresidente creadas por IA en un intento de obtener el apoyo de los votantes negros. Y en noviembre, un vídeo muy falso se volvió viral Gobernador de Florida, Ron Desantis diciendo que abandonaba la carrera presidencial.

«La voz es probablemente el más problemático de todos», afirmó Zohaib Ahmed, director ejecutivo y cofundador de Parecerse a la IA. “La razón por la que la voz es tan problemática es porque simplemente no estamos acostumbrados a ella. Nos llevará algún tiempo educar a la gente sobre ese vector de ataque”.

Aunque a menudo es difícil separar lo real de lo falso basándose únicamente en el contenido, la mejor manera de operar es desarrollar una buena dosis de escepticismo, incluso respecto de tus propias creencias, para no simplemente confirmar tus propios prejuicios, dijo Trielli. “Si ves una imagen que te hace tener una reacción instintiva de odio hacia alguien… (o) si ves algo con lo que estás radicalmente de acuerdo, es cuando debes sospechar”.

Donde falla el ojo humano, existen soluciones técnicas. Varias empresas de tecnología han presentado solicitudes de patentes que buscan resolver el problema de la detección de deepfake, muchas de las cuales dependen de la IA, incluida la presentación de Sony a usa blockchain para rastrear el origen de imágenes y vídeos sintéticos; La patente de Google para detección de vida de datos de voz y la solicitud de Microsoft para tecnología de detección de falsificaciones. Microsoft también buscó patentar una solución que pudiera evitar que las personas crearan falsificaciones profundas, con un modelo de imagen generativa que considera «idoneidad del contenido.”

Las startups también están intentando resolver este problema. Pindrop, por ejemplo, ofrece detección de vida como servicio principal. Mientras tanto, Resemble AI comenzó como una empresa que creaba duplicados de voz generados por IA y desde entonces se ha expandido a la creación de marcas de agua y la detección de falsificaciones profundas. «Construimos un detector de falsificaciones profundas porque empezamos a ver cuán maliciosa podría ser esta tecnología, incluso fuera del alcance de Resemble», dijo Ahmed.

Sin embargo, aún persiste el problema de poner estos mecanismos de defensa en manos de la gente. Si bien algunas formas de detección de spam ya se han adoptado masivamente, como la detección de llamadas spam de Apple, muchas de estas herramientas aún no se han implementado de manera fluida para los consumidores.

Difundiendo la palabra

Ya sea creado para entretenimiento o como una campaña de desinformación real, una vez que el contenido generado por IA está disponible, no es difícil que se propague como la pólvora. Los algoritmos de las redes sociales, a menudo basados en el aprendizaje automático o la propia IA, recompensan la participación por encima de todo. Cuanto más atractivo (y a menudo más lascivo) es un contenido, más viral se vuelve.

«Las redes sociales están diseñadas para optimizar la participación de los usuarios», dijo Brian Green, director de ética tecnológica de la Centro Markkula de Ética Aplicada en la Universidad de Santa Clara. «Si la información errónea promueve la participación de los usuarios, entonces será promovida por los algoritmos que promueven la participación de los usuarios».

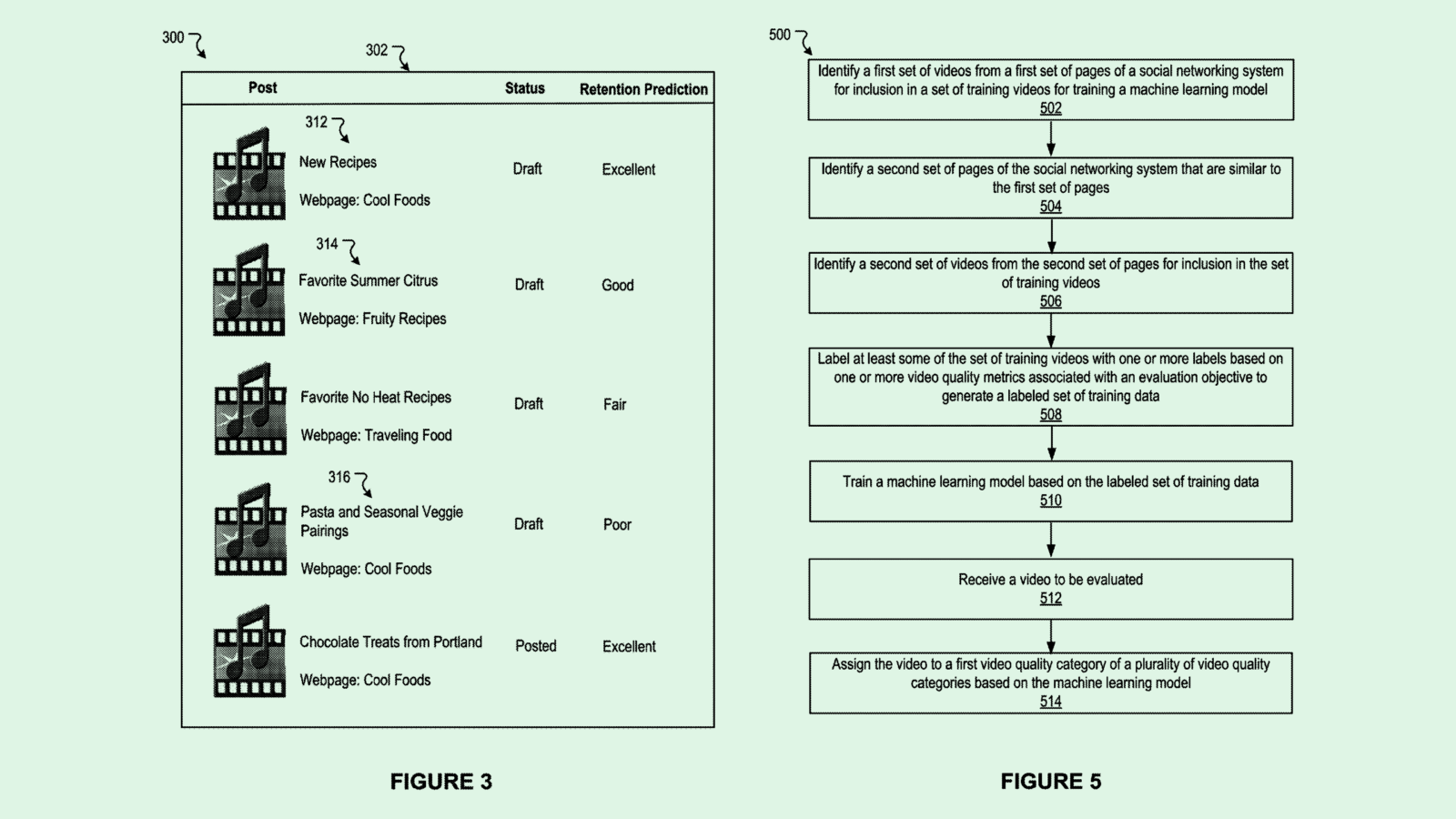

Las empresas de tecnología han tratado de patentar varias herramientas que apuntan a crear y rastrear contenido viral y participación, como la tecnología de Google para predecir la popularidad del contenido; Las patentes de Meta para predecir la calidad del video y colocación de anuncios según señales de participación del usuario; e incluso la patente de Microsoft para un sistema que puede guiar a los usuarios hacia las madrigueras del artículo en función de su sentimiento hacia el contenido (aunque esto se usaría en un navegador, en lugar de en un sitio de redes sociales).

Y dado que una mayor participación genera más dólares en publicidad, estas empresas tienen un incentivo obvio para promover contenido viral, dijo Green. Aunque estas empresas no tienen la obligación legal de regular la información errónea, «(las empresas de redes sociales) tienen una obligación social y una obligación cultural», dijo Green. «Si estamos creando un futuro en el que no podemos distinguir qué es real y qué es falso, entonces realmente nos estamos poniendo en peligro».

Además, en Estados Unidos, la desinformación política generada por la IA no necesita llegar a tanta gente para tener un efecto importante en las elecciones presidenciales, afirmó Trielli. La forma en que está configurado el Colegio Electoral hace que “pequeños cambios en el electorado puedan decidir las elecciones presidenciales”, y sólo unos pocos miles de votantes en los estados indecisos cambian los resultados.

“Tengo una desinformación con la que pretendo cambiar las elecciones, no tengo que convencer a la mayoría de la gente para que crea en esa desinformación”, dijo Trielli. «Sólo necesito unos pocos miles para creerlo». Con la IA, el volumen de este tipo de contenido y la velocidad a la que puede propagarse hace que ese factor sea aún más peligroso, señaló.

Hay que reconocer que varias empresas de tecnología cuentan con políticas de desinformación y contenido de inteligencia artificial: X, anteriormente Twitter, creó una política el pasado mes de abril que prohíbe compartir “medios sintéticos, manipulados o fuera de contexto que puedan engañar o confundir a las personas”, y TikTok agregó etiquetas en septiembre que revelan cuándo el contenido es generado por IA. Meta agregó una característica similar a sus plataformas a principios de febrero en la que los usuarios podían revelar cuándo El vídeo o el audio se generan mediante IA..

Las empresas tecnológicas también han presentado varias patentes para abordar este problema, muchas de las cuales utilizan IA para limitar la propagación. Google presentó una solicitud para patentar una tecnología que podría detectar “campañas operativas de información” en las redes sociales utilizando redes neuronales, así como una aplicación para un sistema para “proteger contra la exposición” a contenido que viole una política de contenido.

Pinterest ha intentado patentar tecnología de eliminación de spam que rastrea contenido malicioso y «indeseable». Y aunque Adobe no tiene su propia empresa de redes sociales, la empresa buscó patentar «corrección de hechos de oraciones en lenguaje natural”, que podría licenciar para plataformas o utilizar en su propia tecnología PDF.

A pesar de estos esfuerzos, controlar el problema de la desinformación generada por la IA es una cuestión de velocidad, afirmó Green. Al final del día, todo se reduce a si la IA que lucha para detectar noticias falsas es más rápida y más fuerte que los algoritmos que las promueven y las herramientas que las crean.

«Va a ser una carrera armamentista», dijo Green. «No está del todo claro qué lado saldrá victorioso».